OpenAIから待望の新型生成AI 「GPT-5」 が登場しました(1)。マルチモーダル能力も向上していると思いますので、早速画像をいくつかアップロードして簡単な実験をしてみたいと思います。それでは始めましょう。

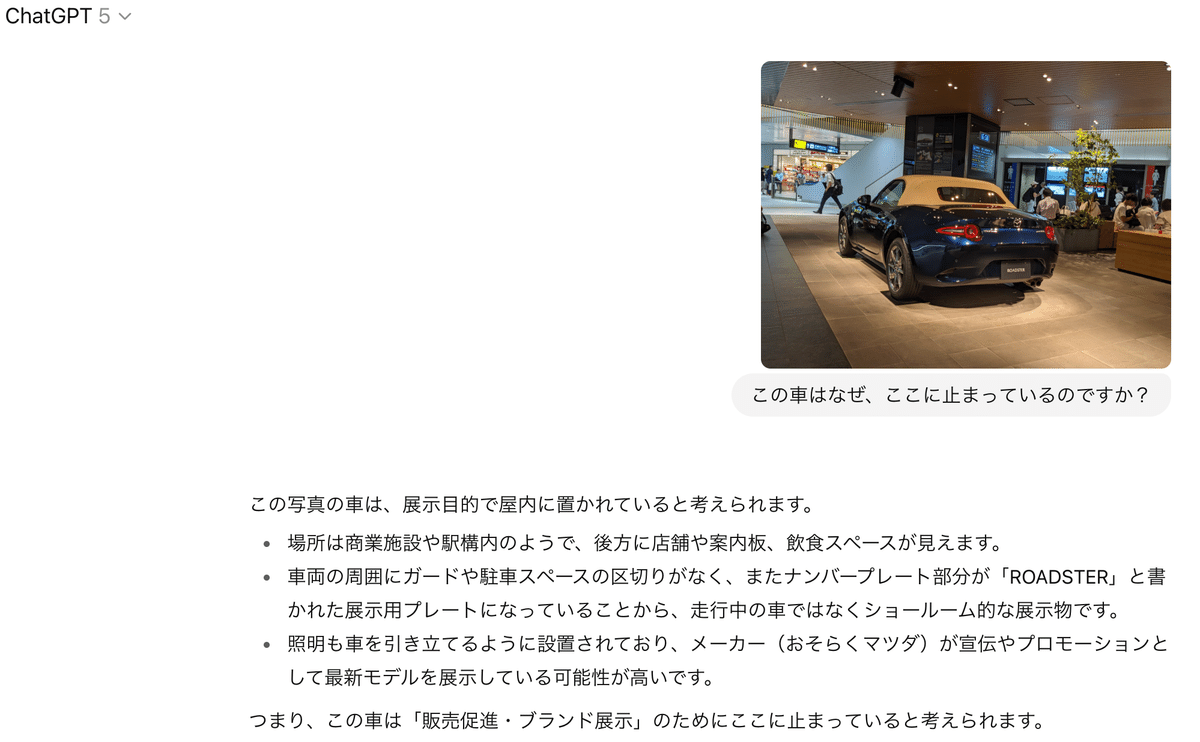

1、自動車が止まってますが、何のために止まってますか?

画像では駅の構内(広島駅)に展示してあるマツダの自家用車が写ってます。これはあくまで展示車ですが、GPT-5が背景等を理解できれば答えらると思います。確かにこれは一般道ではなく、屋内であることを認識できているようです。結果は正解でした。

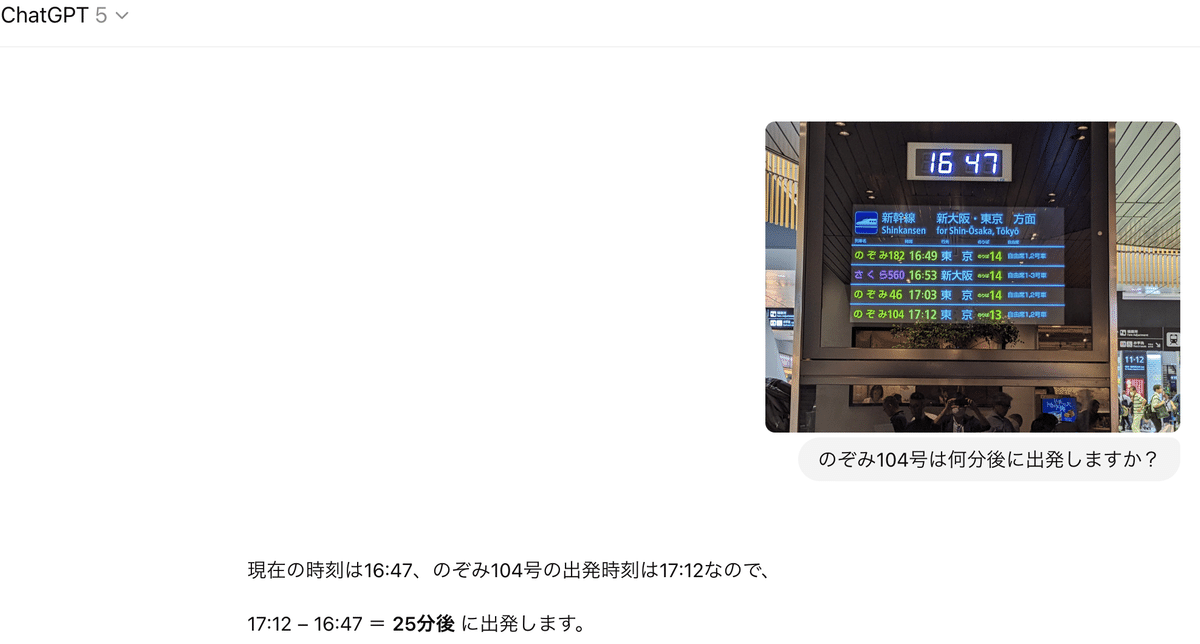

2、出発まで後何分?

旅行しているとよくある場面ですが、乗車する予定の列車「のぞみ104号」が何分後に発車するかを尋ねてます。大きく表示されている時刻が現時刻であることをGPT-5が理解できるかが鍵です。今回もうまくいきました。

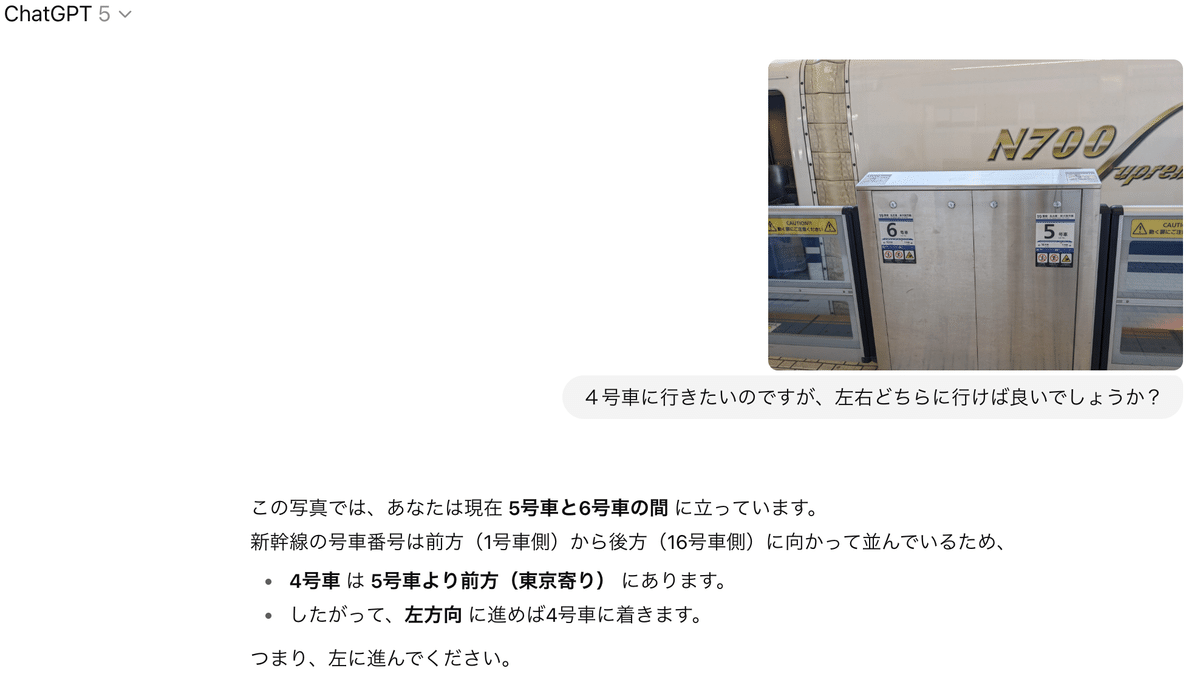

3、4号車はどっちに行けば良い?

これも旅行中によくあるケースですが、東京駅の新幹線ホームで4号車に行きたい時に、以下の表示をみて、左右どちらに行けば良いか尋ねました。結果は「?」でした。

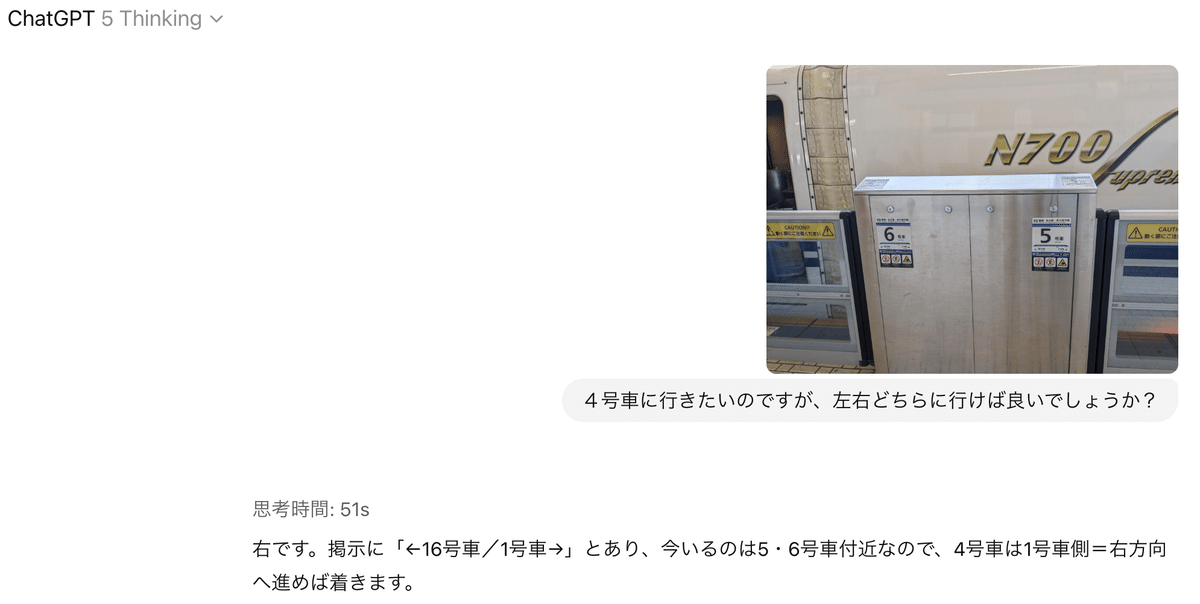

ここで、GPT-5のモードを”Thinking”に切り替えて、もう一度挑戦しました。

結果は正しかったです。”Thinking”ではGPT-5が一生懸命考えるので時間はかかりますが、正しく答えを導くことが多そうです。

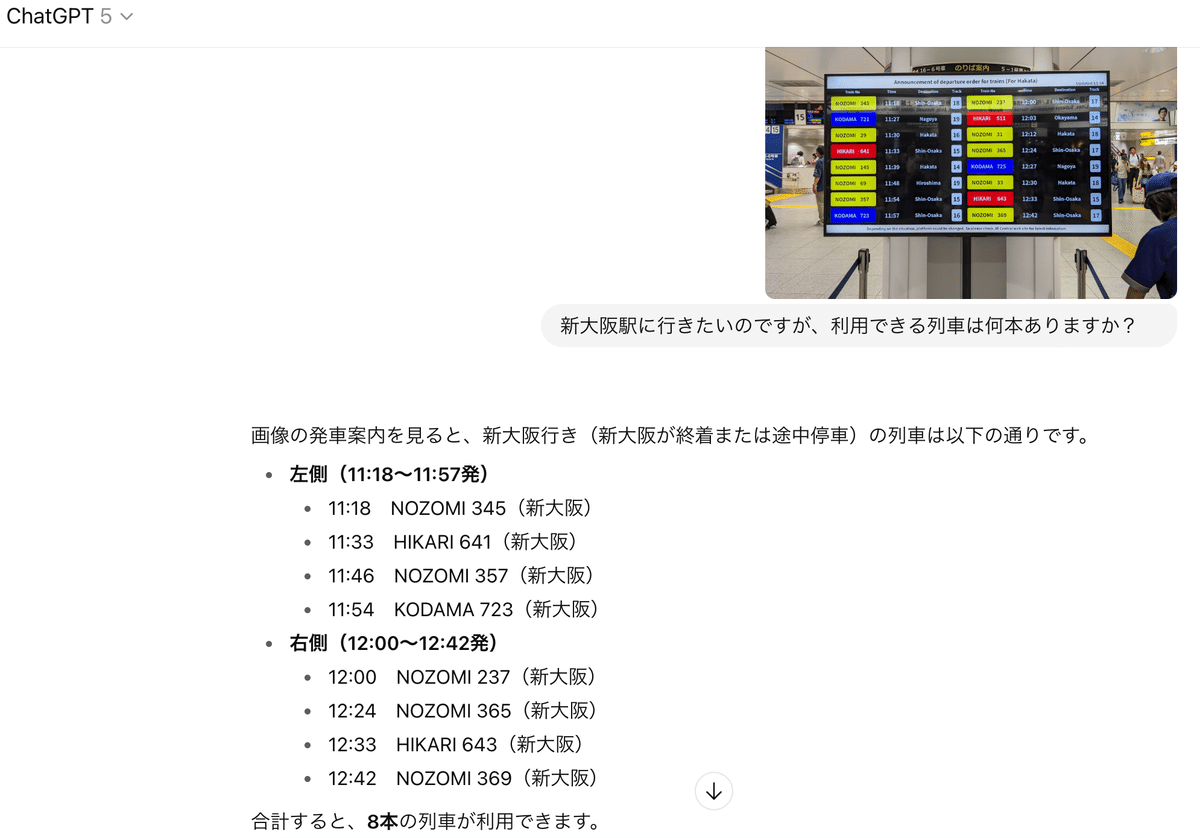

4、新大阪駅に行きたいのですが、利用できる列車はいくつある?

最後は難問です。東京駅の新幹線案内板ですが、行き先が表示されており、全部で16本あります。「新大阪駅に行きたい」と尋ねると8本と答えてきました。これは行き先が新大阪になっている列車の本数ですが、ちょっと短絡的な回答です。例えば博多行き新幹線でも新大阪に行けます。GPT-5はデフォルトのままでは、そこまで頭が回らなかったようです。

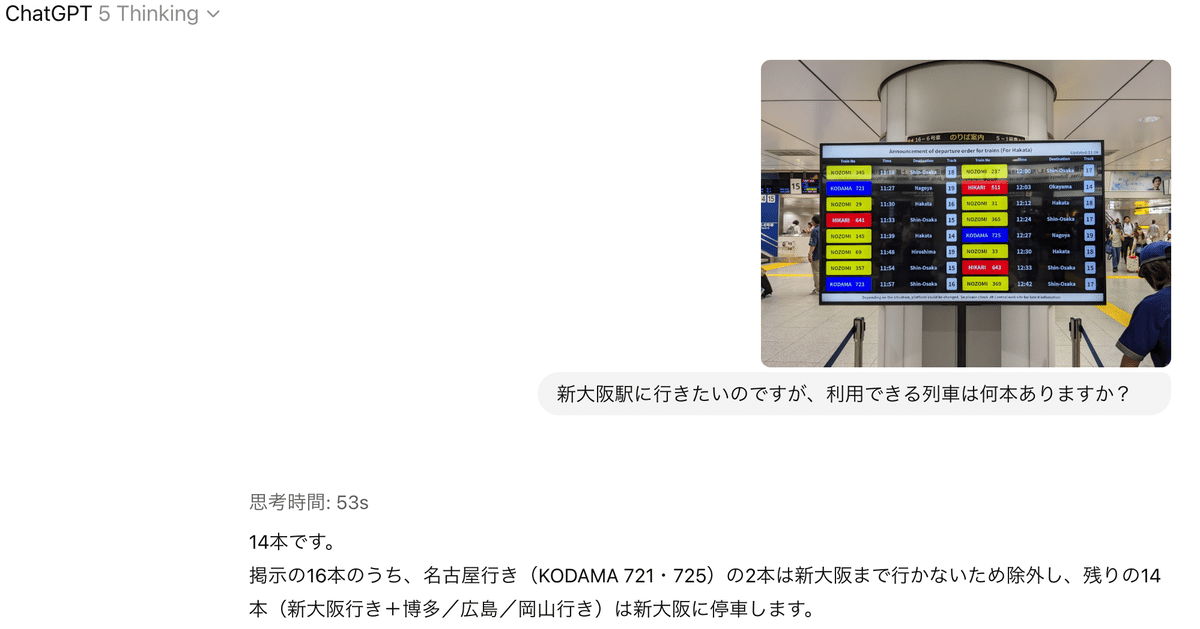

名誉挽回のためにここでも”Thinking”に切り替えて、もう一度挑戦しました。流石に途中の停車駅を考慮した上で、名古屋行き列車を除く14本と回答しました。正解です。

いかがでしたでしょうか?全般的に性能は良好ですね。GPT-5は通常は”Auto”で、難しいタスクになると自動で”Thinking”に切り替わる”a real-time router”を採用しているとのことですが、この切り替えがまだ登場したばかりなので、うまくいかないこともありそうです。上記の例でも”Thinking”が適当なこともありましたので、「ちょっと変だな」と感じる際はには”Thinking”に変更してみることをお勧めします。徐々に安定した運用になることを期待したいですね。GPT-5については将来もまた取り上げたいと思います。お楽しみに。Stay tuned!

Copyright © 2025 Toshifumi Kuga. All right reserved

1) GPT-5 System Card., OpenAI, August 7, 2025

Notice: I do not accept any responsibility or liability for loss or damage occasioned to any person or property through using materials, instructions, methods, algorithms or ideas contained herein, or acting or refraining from acting as a result of such use. I expressly disclaim all implied warranties, including merchantability or fitness for any particular purpose. There will be no duty on me to correct any errors or defects in the codes and the software.